In diesem Beitrag erfahren Sie, wie Sie die Datei robots.txt in Blogger (Blogspot) erstellen und ändern, eine Sitemap in die robots.txt einbinden und Robot Meta Tags anpassen können.

XML Sitemap in Blogger

Mit XML-Sitemaps kann man Google über alle Seiten der Webseite informieren, die indexiert werden sollen. Das führt zur schnelleren und korrekten Indexierung der neuen Seiten.

Die XML Sitemap wird bei Blogger automatisch generiert und befindet sich auf Blogspot Blogs unter folgender Adresse:

http://IhrBlog.blogspot.com/sitemap.xml (z.B. http://test4box.blogspot.com/sitemap.xml )

Diese Adresse sollten Sie in robots.txt angeben (siehe unten)

robots.txt in Blogger hinzufügen und Sitemap einbinden

Mit robots.txt kann man Google und andere Suchmaschinen über die Webinhalte informieren, die durch Webcrawler nicht durchgesucht werden dürfen.

Damit vermeidet man z.B. die Indexierung der duplizierten Inhalte, was für SEO sinnvoll ist.

Die Datei robots.txt befindet sich unter:

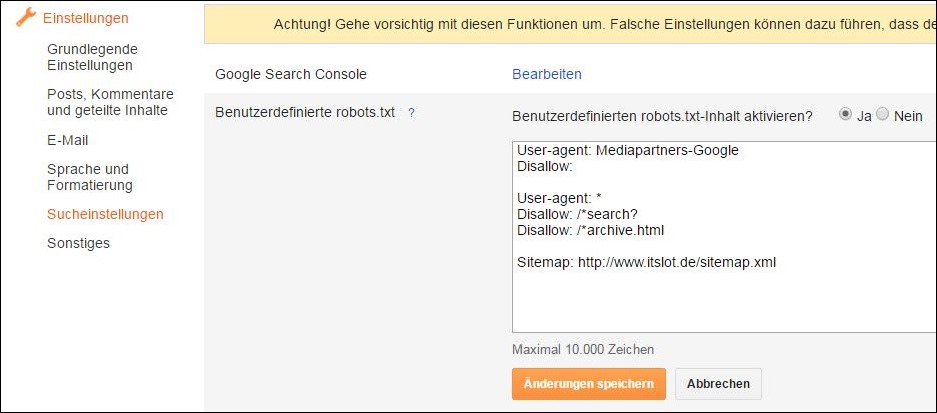

blogger.com > ihrblog.blogspot.com > Einstellungen > Sucheinstellungen

Dort kann man “Benutzerdefinierte robots.txt” aktivieren und gewünschte Parameter eintragen:

robots.txt Beispiel für Blogger (Blogspot)

So sieht die Datei robots.txt von www.itslot.de aus (Stand: 19.07.15):

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /*search?

Disallow: /*archive.html

Sitemap: http://www.itslot.de/sitemap.xml

Erklärung:

Der AdSense-Crawler (Mediapartners-Google) darf in diesem Beispiel alle Seiten indexieren.

Für alle anderen Suchmaschinen (User-agent: *) gilt: Die Suche- und Archiv-Seiten sind aus der Indexierung ausgeschlossen. Diese dürfen also nicht indexiert werden, denn diese Seiten enthalten duplizierte Inhalte.

Anschließend wird die Sitemap angegeben. Wo Sie die Sitemap finden, habe ich bereits beschrieben.

Die Datei robots.txt befindet sich bei Blogspot Blogs unter folgender Adresse: http://IhrBlog.blogspot.com/robots.txt (z.B. http://test4box.blogspot.com/robots.txt)

Es gibt im Netz viele Beispiele für robots.txt und jeder sollte selbst entscheiden, welche Inhalte nicht indexiert werden dürfen. Am meisten wird robots.txt dazu verwendet, um die Indexierung der duplizierten Inhalte zu vermeiden. Sie können das Beispiel von itslot.de gerne als eine Vorlage für eigenen Blog verwenden.

Ich empfehle Ihnen außerdem, die Sitemap-Adresse in Google Webmaster-Tools einzubinden. Dann können Sie in Google Webmaster-Tools gleich sehen, ob die Sitemap korrekt ist und wie viele Seiten in der Sitemap gefunden wurden.

Blogger.com: Robot Meta Tags

Einstellungen > Sucheinstellungen > Benutzerdefinierte Robots-Header-Tags:

Archiv und Suchseiten: noindex + noarchive

http://yourblogname.blogspot.com/atom.xml?redirect=false&start-index=1&max-results=500

AntwortenLöschenHallo, manche Webseiten empfehlen eine xml-Datei der Sitemap zu kreieren, damit wirklich alle posts gefunden werden. Was weißt du darüber?

Google akzeptiert Sitemaps in den Formaten XML, RSS oder Atom. Sie empfehlen , sowohl XML-Sitemaps als auch RSS/Atom-Feeds für ein optimales Crawling zu verwenden.

MfG

Hallo, Sitemap wird doch bei blogger.com Blogs automatisch generiert, du brauchst diese nicht manuell zu erstellen.

Löschen